Die Google Search Console Basics

Anmeldung der Google Search Console

Die Google Search Console ist nicht öffentlich zugänglich und benötigt daher ein Benutzerkonto sowie eine Anmeldung vor jeder Nutzung. Nach der ersten Anmeldung muss der Besitzer die Seite zudem verifizieren. Hierfür stehen verschiedene Methoden zur Auswahl:

- Der Upload einer HTML-Datei

- Die Überprüfung via Domain Name Provider

- Der Einsatz eines HTML-Tag

- Das Google Tag Manager-Container-Snippet

- Der Google Analytics-Tracking-Code

Ist Google Analytics für die Website ohnehin im Einsatz, empfehlen wir die Verifizierung über den Google Analytics-Tracking-Code. Ansonsten bietet der Einsatz des HTML-Tag unserer Meinung nach die unkomplizierteste Form der Verifizierung.

Nach Auswahl einer Bestätigungsmethode und der korrekten Implementierung bietet die Google Search Console alle relevanten Daten für die Website an und die üblichen Funktionen sind verwendbar

Darstellung der Suche

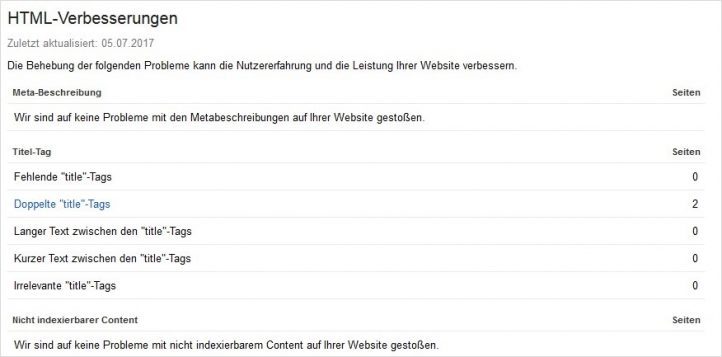

Sind HTML-Verbesserungen auf der Website notwendig?

Dieser Menüpunkt zeigt verbesserungswürdige Faktoren, wie den Einsatz doppelter, zu langer oder irrelevanter HTML-Tags wie <title> -Tags oder <meta-description> -Tags.

Da die Suchmaschine den Inhalt einer Seite unter anderem auch aus den Meta-Daten ermittelt, ist es sehr wichtig, dass diese Bestandteile stets Keywordrelevant und in der entsprechenden Länge formuliert sind. Mithilfe der HTML-Verbesserungen aus der Google Search Console sieht man unpassende Meta Daten auf den ersten Blick und kann diese dann optimieren.

Suchanfragen

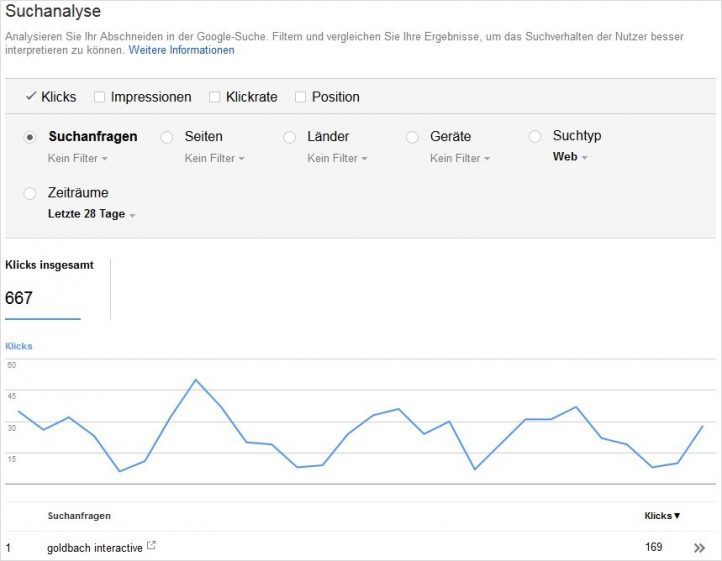

Die Suchanalyse

Anhand der Suchanalyse lässt sich ermitteln, wie die Website hinsichtlich der Klicks, Impressionen, Positionen und Klickraten innerhalb der Google-Suche abschneidet. Es werden beispielsweise Seiten mit besonders guten oder schlechten Klickraten angezeigt sowie die Suchzugriffe im Zeitverlauf und deren Herkunft.

Die Ergebnisse eignen sich sehr gut als Grundlage zur Entwicklung einer Optimierungsstrategie unter anderem hinsichtlich der verwendeten Suchbegriffe.

Links zu Ihrer Website

Mit diesem Punkt kann man ermitteln, welche Links auf eine Website verweisen.

Nutzerfreundlichkeit auf Mobilgeräten

Eine neuere Ergänzung ist der Unterpunkt „Nutzerfreundlichkeit auf Mobilgeräten“, der auf mögliche Probleme bei der Präsentation auf mobilen Geräten hinweist.

Die Bedeutung der Nutzerfreundlichkeit auf Mobilgeräten hat in den letzten Jahren aufgrund der gestiegenen Nutzung von Smartphones und Tablets stark zugenommen. Daher werden Websites mit Problemen bezüglich der Nutzererfahrung auf Mobilgeräten in den Suchergebnissen möglicherweise schlechter eingestuft.

Google-Index

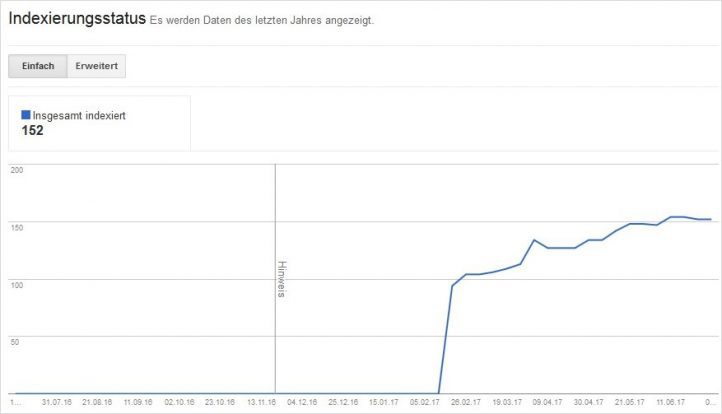

Sind die Seiten der Website im Index?

Der Indexierungsstatus gibt im Zeitverlauf über ein Jahr die Anzahl der URLs wieder, die in den Suchergebnissen angezeigt werden. Die Anzahl kann variieren, wenn URLs hinzugefügt oder auch entfernt wurden.

Der Indexierungsstatus zeigt zwar nicht die konkreten URLs der indexierten Seiten an – es lohnt sich aber trotzdem ihn regelmäßig zu beobachten. Sprunghafte Veränderungen nach oben können darauf hinweisen, dass die Suchmaschine Seiten indexiert, die vorher nicht verfügbar waren. Ein plötzlicher Abfall der indexierten Seiten kann wiederum darauf hinweisen, dass man Unterseiten versehentlich für Suchmaschinen gesperrt hat.

Crawling

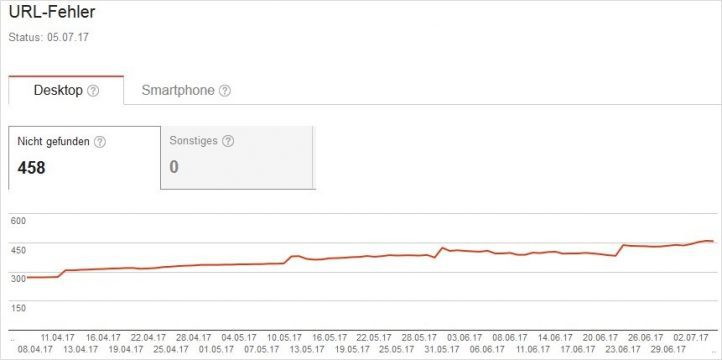

Crawling-Fehler

Ändert sich beispielsweise die Seitenstruktur der Website, ohne eingerichtete Umleitungen, stellt Google fest, dass die Seite nicht mehr existiert und listet in der Search Console eine Fehlermeldung auf.

Hier lohnt sich ebenfalls eine regelmäßige Prüfung, um zeitnah Redirects einrichten zu können. Denn sonst kann die Seite wertvollen Link Juice verlieren.

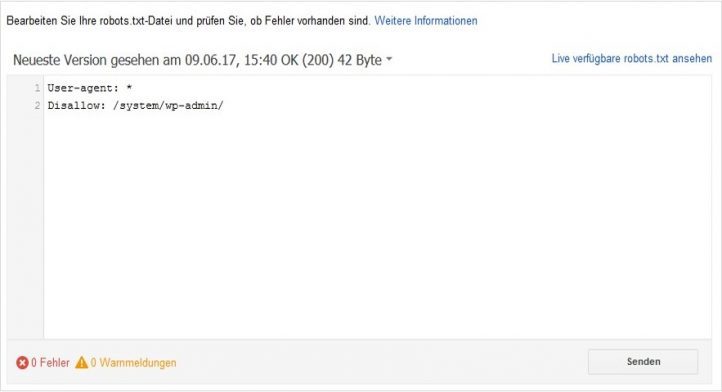

robots.txt-Tester

Die robots.txt ist ein Dokument, mit dem man steuern kann, wie Crawler von Suchmaschinen mit der Webseite umgehen sollen. In diesem kann man Ordner und Dateien angeben, die die Suchmaschinen nicht lesen sollen. Laut Google ist eine robots.txt Datei dann von Vorteil, wenn die Website Inhalte enthält, die Suchmaschinen nicht indizieren sollen. Sobald die Indizierung der gesamten Website erlaubt ist, braucht es im Grunde keine robots.txt-Datei.

Sitemaps

Bei XML-Sitemaps handelt es sich um Listen, die man im XML-Format erstellt und die alle Unterseiten einer Website enthalten. Man kann diese in der Google Search hochladen, um der Suchmaschine alle Seiten einer Website zu übermitteln. Das unterstützt sie beim Crawlen.

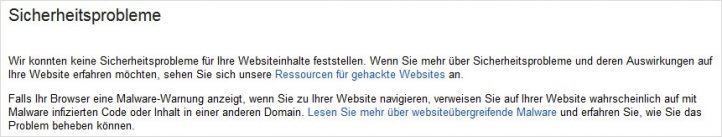

Sicherheit

Der Menüpunkt „Sicherheitsprobleme“ würde eine Meldung anzeigen, sobald Probleme, die die Sicherheit betreffen, wie z. B. Standorthacks und Malware, vorhanden wären.

Bei Meldungen in diesem Bereich sollte man sofort aktiv werden!

Bei generellen Fragen zur Google Search Console oder wenn Hilfe bei der Einrichtung eines Umleitungsprozesses oder einer Liste benötigt wird, helfen wir gerne.